DIEGO CASADO-MANSILLA JUAN LÓPEZ-DE-ARMENTIA

Investigadores de DeustoTech Internet

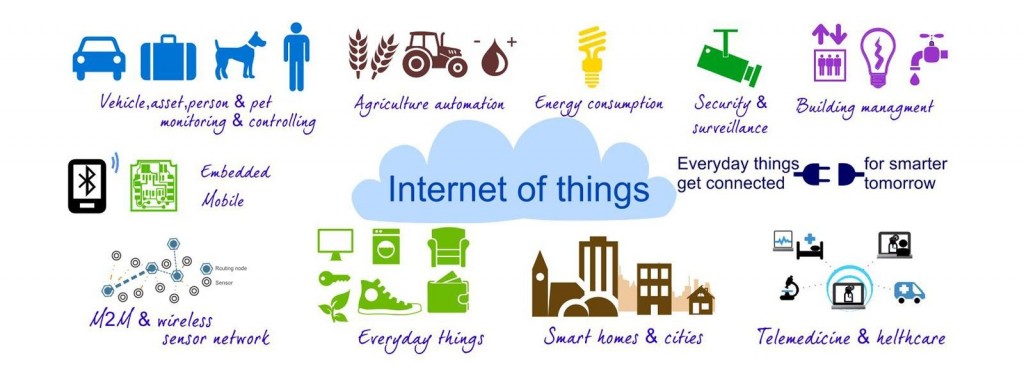

El concepto Internet de las Cosas (Internet of Things – IoT, en inglés) radica en que los objetos que nos rodean y que usamos diariamente estén conectados a Internet en cualquier momento y lugar. Este concepto está altamente relacionado con la Ubicuidad.

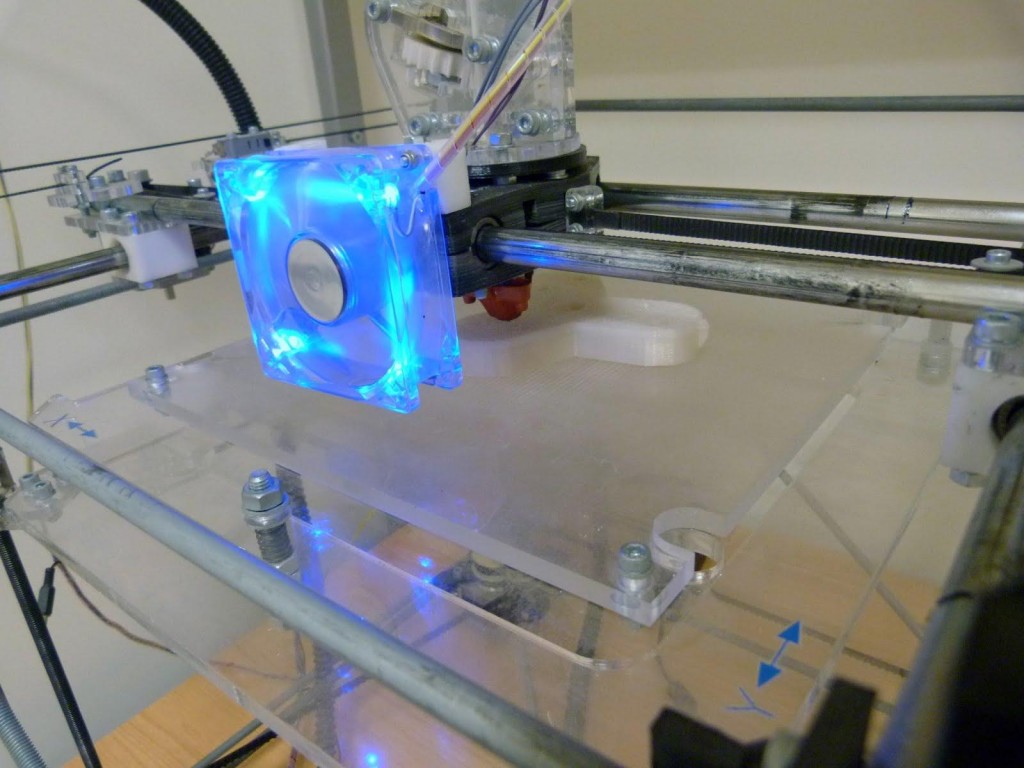

En términos más técnicos, diríamos que consiste en integrar una serie de componentes electrónicos en la fase de diseño de estos objetos cotidianos con el fin de dotarles de conectividad a Internet. Dado que Internet está presente en casi cualquier rincón del planeta y que el tamaño y coste de la electrónica ha disminuido de manera notable en las últimas décadas, cualquier objeto es susceptible de ser conectado, manifestarse en la Red y actuar como fuente de datos.

La conectividad a la Red es la base del Internet de las Cosas. Sin embargo, los objetos conectados deben desempeñar un rol para sacar rédito a su ubicuidad y poder ser considerados como objetos inteligentes. Para ello, son necesarios tres pilares: 1) componentes computacionales que permitan procesar información —ej. micro-controladores—; 2) sensores que permitan obtener información física del entorno y convertirla en información procesable digitalmente —ej. luminosidad, movimiento, temperatura—; y 3) actuadores, que son dispositivos electrónicos que permiten modificar o generar un efecto sobre la física del entorno —ej. motores, altavoces—.

Las aplicaciones del Internet de las Cosas cubren un amplio espectro de nuestra vida cotidiana. Uno de los campos en el que está empezando a tener y se prevé tendrá gran relevancia, es las sostenibilidad medioambiental.

Como ejemplo, se citan algunos proyectos e iniciativas que se están llevando a cabo en el ámbito de la ciudad, espacios públicos y hogar. En el proyecto PEACOX[1] se monitorizaba la calidad del aire con la

idea de promover el uso de rutas alternativas con baja contaminación atmosférica para conductores, ciclistas, viandantes. Cada vez más proyectos optan por el uso de IoT para gestionar el tráfico de forma más eficiente a través de sensores desplegados en la ciudad[2]. En el campo de los edificios públicos, uno de los objetivos del nuevo programa H2020 apunta al diseño de sistemas de control de presencia para hacer un uso eficiente de la calefacción y alumbrado por zonificación[3]. Por último en el ámbito del hogar la domótica copa la mayoría de los proyectos de IoT (lavadoras que ajustan su programa al momento del día en que la energía es más barata y proviene de fuentes renovables, termostatos inteligentes que aprenden las preferencias[4] y horarios de los habitantes del hogar para realizar un uso eficiente de la calefacción sin perder confort, o electrodomésticos inteligentes que son capaces de aprender la forma y frecuencia en la que son utilizados con el fin de promover un uso eficiente de los mismos[5].

A vista de todos está que la tecnología ubicua está aquí para quedarse y debemos aprender a convivir con ella, pero teniendo presente que no va a ser la solución a los malos hábitos de la sociedad. Desde la visión de DeustoTech Internet, en ocasiones la automatización y cooperación entre dispositivos para realizar una cierta tarea será la mejor opción, en otras, la cooperación entre objetos cotidianos y humanos será lo más adecuado. Pero siempre habrá ciertas tareas que realiza el ser humano en las que no existe posibilidad de reemplazo.

Ahora toca reflexionar al lector. ¿Quién debe asumir la responsabilidad de las tareas cotidianas? ¿Las máquinas,

los humanos o la deben compartir entre ambos? Nuestra recomendación: apelar al mejor de los sentidos… el tan denostado sentido común.

Seguir leyendo El Internet de las Cosas y la sostenibilidad medioambiental