Autor: Jose Luis del Val Catedrático del departamento de Telecomunicaciones

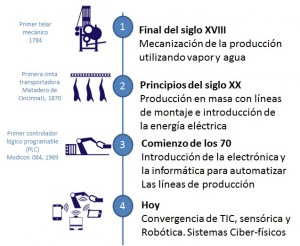

El término industria 4.0 se creó en Alemania para hacer referencia a la transformación digital de la industria, también conocida como “Fábrica Inteligente” o «Internet industrial».

El avance incontenible de Internet ha tenido un impacto radical en la economía y en la sociedad del siglo XXI. La convergencia de las tecnologías de la información (TIC) con la sensórica y la robótica han transformado la internet tradicional en internet de las cosas (IoT). El resultado en la industria ha sido un nuevo modelo organizativo y un cambio disruptivo en la industria que algunos denominan la “cuarta revolución industrial”.

La industria está sometida a una gran presión sobre su competitividad y una robotización aún más intensiva se contempla hoy como oportunidad para reducir costes. Pero, además, han cambiado los intereses de los clientes; los nuevos mercados se basan en la personalización y la creación de nuevos productos y servicios innovadores. Los clientes están más dispuestos a pagar por la experiencia o el servicio que por el producto en sí. Por ello la industria necesita añadir al producto servicios nuevos, experiencia individualizada, capacidad de actualización, lo que pasa por añadir software y conectividad a cualquier producto. La industria 4.0 da respuesta a ambas exigencias y ofrece a Europa la oportunidad de recuperar buena parte de la industria que se perdió en las últimas décadas.

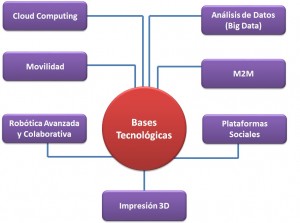

Tecnologías Básicas en que se sustenta la industria 4.0

La industria 4.0 se sustenta en un conjunto de tecnologías clave que, combinadas, posibilitan un nuevo modelo industrial.

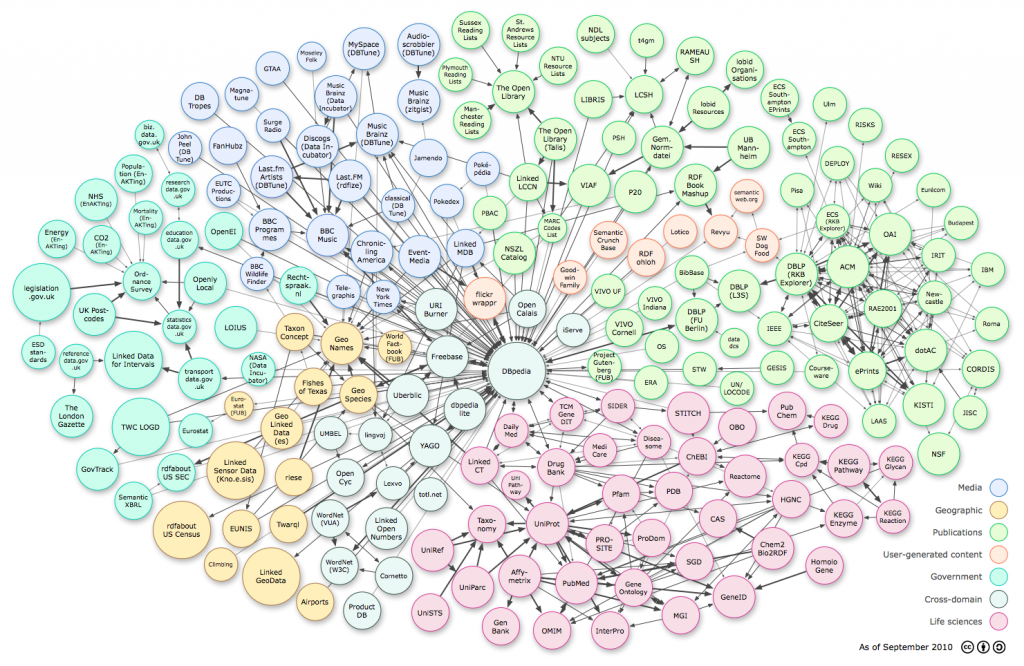

La internet móvil y la comunicación M2M son la base de IoT. Permiten intercambiar información entre sistemas y productos, capturar datos, coordinar sistemas y desplegar servicios remotos. Al mismo tiempo, este aumento de conectividad lleva a la necesidad de proteger los sistemas industriales de las amenazas a la seguridad.

El análisis de datos (Big Data) permitirá identificar patrones e interdependencias, encontrar ineficiencias e incluso predecir eventos futuros. Las aplicaciones e infraestructuras ofrecidas en la nube (Cloud Computing) y pagadas por uso (as a service) harán posible el flujo masivo de datos y su análisis con una flexibilidad sin precedentes.

La impresión 3D (Fabricación Aditiva) permite producir objetos tridimensionales a partir de modelos virtuales facilitando crear prototipos, fabricar productos personalizados y una producción descentralizada.

Los sistemas basados en la realidad aumentada permitirán proporcionar a los trabajadores información en tiempo real para mejorar la toma de decisiones e incrementar la seguridad. Los robots colaborativos serán capaces de trabajarán con seguridad junto a los seres humanos, aprendiendo de ellos y ofreciendo autonomía, flexibilidad y cooperación.

Además de la fábrica física, conectada e inteligente, puede construirse una réplica virtual para simular procesos de fabricación completos.

La fábrica inteligente

La fábrica inteligente es el resultado de la fusión de los mundos virtual y físico.

Las piezas base son los productos inteligentes, caracterizados por disponer de electrónica, software embebido y conectividad. Se denominan sistemas ciber-físicos (CPS) y tienen capacidad de interactuar con otros sistemas (M2M) y con humanos. El software les permite auto-gestionarse y tomar decisiones descentralizadas. Equipados con sensores captan información sobre su entorno, su uso y estado que pueden proporcionar a quien lo fabricó o gestiona su servicio. Sobre los CPS pueden ofrecerse servicios inteligentes y establecer nuevos modelos de negocio, aprovechando combinaciones innovadoras de servicios inteligentes para incrementar la creación de valor, aguas arriba o abajo de la cadena de valor.

Estos mismos principios se aplican a las máquinas que los fabrican, los sistemas de producción ciber-físicos (CPPS), que constituyen la “Fábrica Inteligente”. Son máquinas con capacidad de comunicación, personalización, adaptación al entorno y flexibilidad.

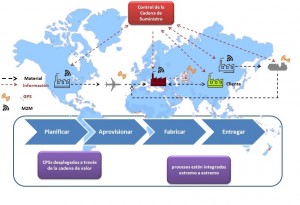

La cadena de suministro inteligente y conectada es otra pieza central en la Industria 4.0. Los flujos físicos se replican en una imagen virtual a través de materiales y piezas etiquetadas con RFID. A lo largo de la cadena de suministro, los CPS generan datos sobre su posición y estado. La digitalización permite automatizar los procesos e identificar al producto a lo largo del proceso. La visibilidad de los movimientos en la red de suministro permite reconocer ineficiencias y riesgos, aumentar la robustez y la capacidad de respuesta a incidencias, incrementar la fiabilidad y disminuir los costes.

La cadena de suministro inteligente y conectada es otra pieza central en la Industria 4.0. Los flujos físicos se replican en una imagen virtual a través de materiales y piezas etiquetadas con RFID. A lo largo de la cadena de suministro, los CPS generan datos sobre su posición y estado. La digitalización permite automatizar los procesos e identificar al producto a lo largo del proceso. La visibilidad de los movimientos en la red de suministro permite reconocer ineficiencias y riesgos, aumentar la robustez y la capacidad de respuesta a incidencias, incrementar la fiabilidad y disminuir los costes.

El resultado es una cadena de producción donde cada sistema es capaz de obtener la información que necesita. La fábrica se convierte en una red de agentes que toman decisiones optimizadas. La producción puede organizarse según un modelo donde la capacidad de los sistemas es la oferta y la demanda surge de las órdenes que deben atenderse. Cada CPPS puede decidir su programa de producción en base a su tiempo de procesamiento, las fechas de entrega u objetivos de beneficio o sostenibilidad. Gracias a su autogestión, productos y máquinas inteligentes se vuelven invisibles a los operadores y sólo precisan atención cuando precisan mantenimiento.